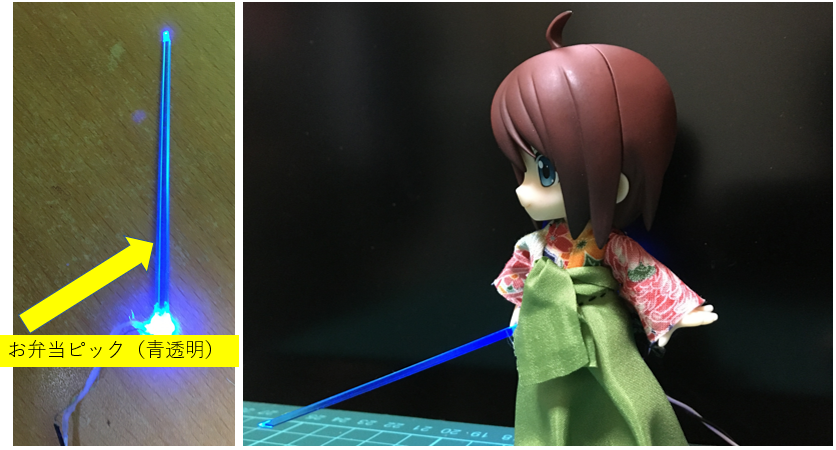

小さいものの工作をするときに便利な部品の一つにLEDがあります。LEDは、取り付けるだけでアクセントとなるので重宝します。また、鉄道模型などを作成するときにLEDが必要な場合があります。

秋月電子などの電子部品の取り扱い店では表面実装LED(1608等)をリード線に取り付けたものが売られています。(参考→https://akizukidenshi.com/catalog/g/gI-09957/)質はいいとは思いますが、値段は1つ30~40円と壊れるリスクを考えると少々お高めです。また、リード線は見た感じ曲げにくい形状をしています。

最初から用途ががっちりと決まっていれば、迷わず購入するところですが、私のようにお金のない学生にとっては送料を含めて少し痛い出費になるので、手持ちの表面実装LEDとリボンケーブルを使ってリード線付き表面実装LEDを作りました。

1回目

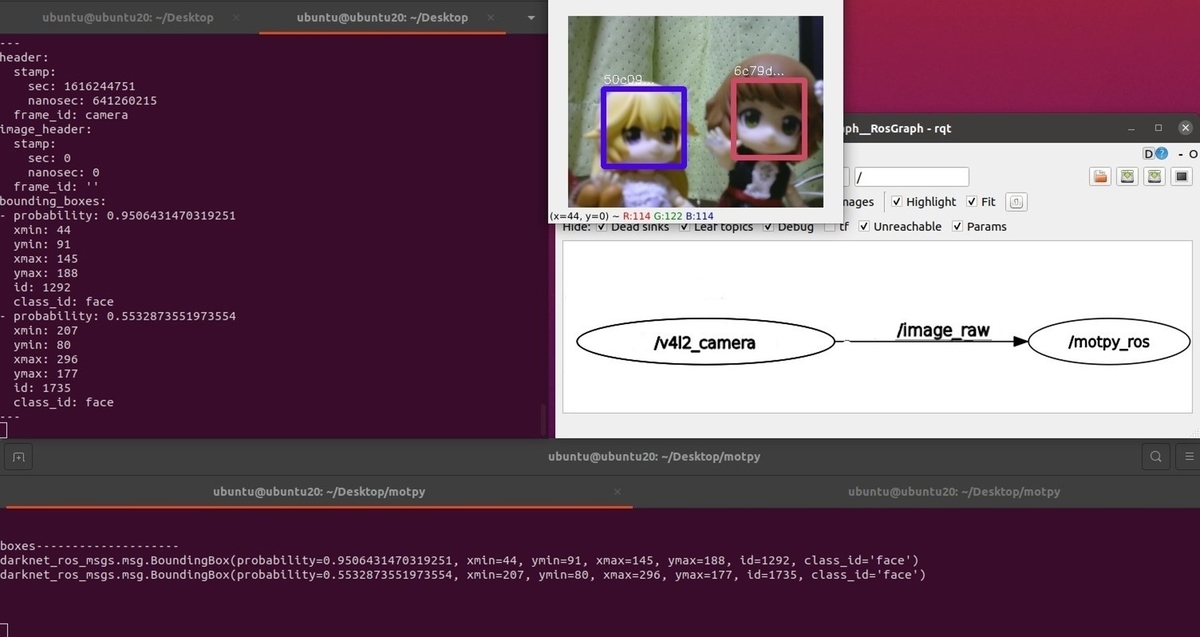

1回目の試作は、卒研発表会前日に作成しました(馬鹿か)。

少し太めの線で作りました。リボンケーブル側にはんだを盛ってからLEDとはんだ付けするようにするとそこそこうまくいきます。しかし、接触があまりよくなかったみたいで、場合によっては通電しないことがありました。また、線が太かったので曲げにくく、線が目立ちました。

2回目

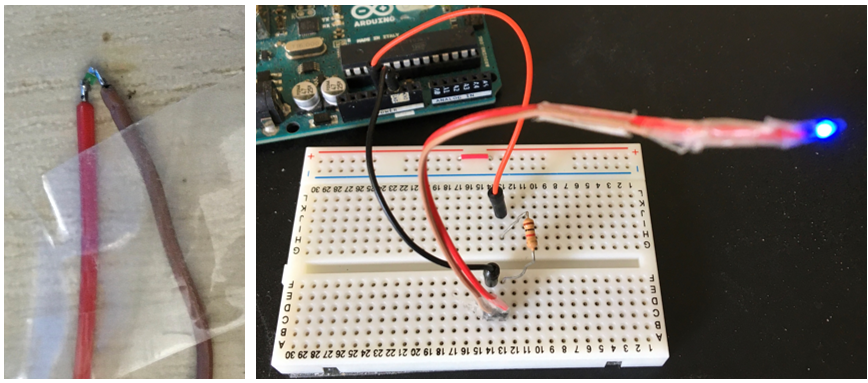

2回目は、1回目の反省を踏まえてより細いリボンケーブルを採用しました。また、導線を露出することで、さらに細くしました。絶縁については、片方のケーブルをセロハンテープで包むことにしました。(ショートしても、抵抗があるので大丈夫です)

また、LEDと導線のはんだ付けについても少し改良しました。これまでは、線の先とLEDの極をはんだ付けしていましたが、線の腹の部分とLEDの端子をはんだ付けして線をカットしました。「見た目くっついているけど実はくっついていない」事故を回避するためです。

ライトセーバー風にアレンジ

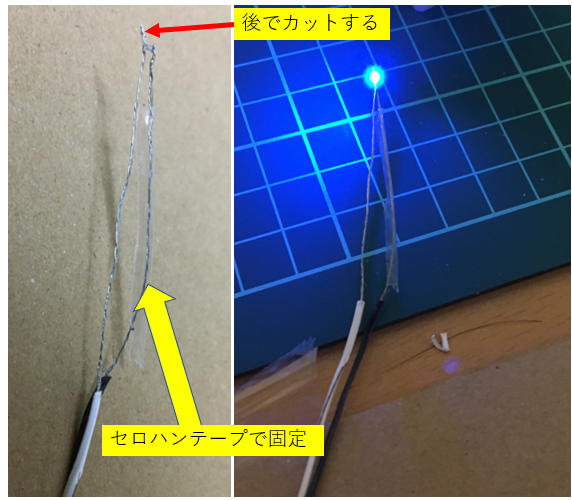

2回目で製作したリード付LEDをライトセーバー風にアレンジしました。

剣については、ダイソーで購入したお弁当用のピックを加工して作りました。LEDとピックはホットボンドで接着しました。

おわりに

既製品よりもフレキシブルなリード付LEDを自作することができました。さらに細さを突き詰めていけば布への組み込みも可能になるかもしれません。難易度は高いですが、次はフルカラーLEDをリード付きにしたいですねー。