このブログは開設から4年経過しました。これまでで228本の記事、累計閲覧数 15.1万(1年で6.7万増加)のブログ記事となりました。いつもご覧頂きありがとうございます。

4年前の記事→初投稿 - えいあーるれいの技術日記

3年前の記事→ブログ開設1年。これまでとこれからについて - えいあーるれいの技術日記

2年前の記事→ブログ3年目。 - えいあーるれいの技術日記

1年前の記事→ブログ4年目。 - えいあーるれいの技術日記

素晴らしく順調

昨年は

今年度から社会人(?)で普通に業務に取り組まなければいけませんが、数年間文章を書きつづけられているのでこれからも変わらず書き続けられると思います。

と意気込んでいましたが、質を落とすことなく(なんならインフレ気味)継続できました。

仕事の順調さについても、私の活動範囲とそのスピードが証明していることでしょう。

しかしながらまだまだ足りません。

年間の1/3は体調がよくなかったのですから。昨年の反省を生かしつつ今年は昨年の倍頑張ります。

未知を走る自称若者に甘えなんて許されません(戒め)

軽く振り返り

振り返ってみると、今年は前半節約志向、後半になってようやくまともな技術記事になっていました。

割と本当に財布の余裕がダイレクトに影響するのかもしれない。つらー😇

クレカの上限が20万くらいしかなかった頃に20万くらい月で使って詰みかけていたので大変だった(気がする

ar-ray.hatenablog.com

1年前は通信費もケチっていました。半年前に訪問系セールスに敗北してからは光通信を使っています。快適。

ちなみにルータについては、スマホがないとログインできなかったりとゴミ仕様だったので捨てました。

ar-ray.hatenablog.com

すごく高品質な画像も8GBくらいのRAMで生成できるようになって驚いたのでその画像で壁紙を作っていました。

背景切り抜きについてはiPhoneやphotoshopで十分対応できてしまうので、この回でLinyax最終回です。

ar-ray.hatenablog.com

1.5万で2560x1600の格安モバイルディスプレイも購入しましたね。

今も大活躍中です。タブレット用スタンドと組み合わせて使っています。

ar-ray.hatenablog.com

みなさんは「からあげ帝国」というのを知っていますか?

ブログ・AIで有名な闇のエンジニアの「からあげ先生」のファンコミュニティです。

私もこの第一回オフ会に昨年参加しました。

このオフ会により、からあげ先生が闇のエンジニアから引退されたお話は後世に語り継がれることでしょう。

ar-ray.hatenablog.com

「ハードウェア方面も力入れたい」と一昨年から思っていたことの第一弾となる記事です。

こういう作業はドライバ作成から始まるので、なかなか作るものがないとモチベにならないのが辛いところだったので、2軸とディスプレイで構成されるスタックチャンは非常にありがたい存在です。

メイカーフェアだけでなく深圳にも持っていってもらい、スタックチャンの生みの親であるししかわ様に感謝です🙏

今後とも私が作成される資料にちまちま登場することでしょう。

ar-ray.hatenablog.com

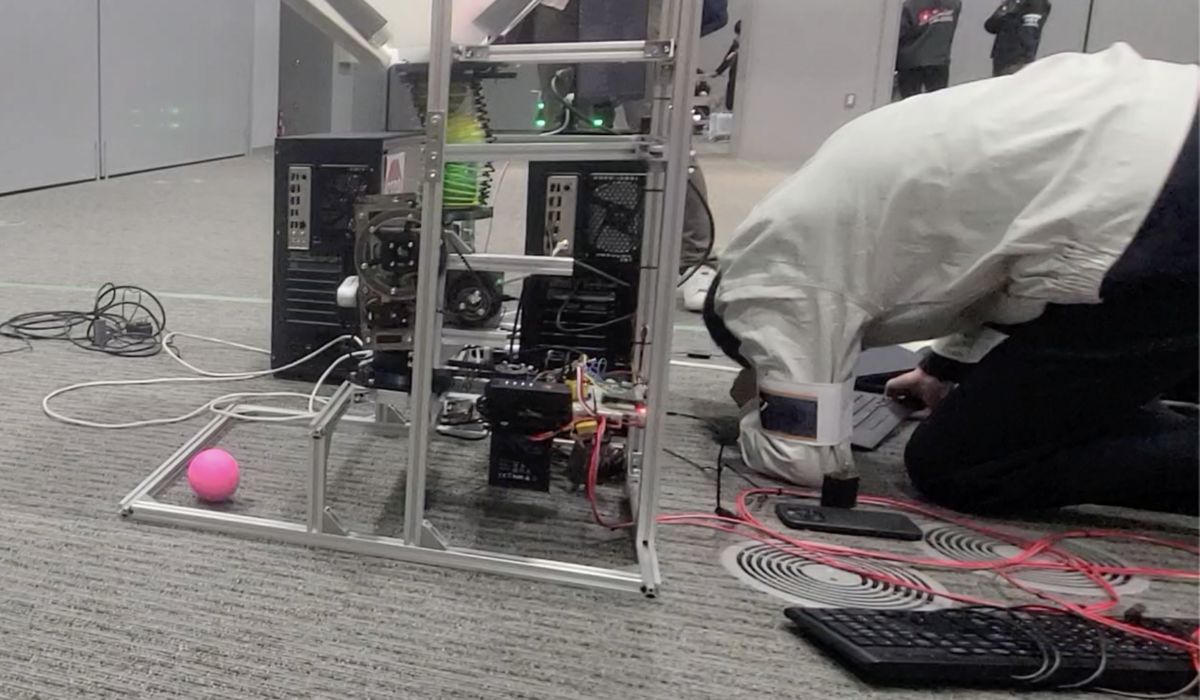

10月末に唐突にロボコンする!と言い出してからもう半年です。時間が経つのは早いですね。

「CoRE-1」(The Championship of Robotics Engineers)というロボット競技が今年から正式に始まりました。

CoREは走行するロボットがフライングディスクを互いのロボットの的に当て合う競技ですが、異なるチームが「同盟」として協力して対戦するルールやエンジニアの活動にスポットライトを当てる評価制度があり、他のロボコン競技とは少し性質が異なります。

core.scramble-robot.org

参加対象が広いことやハードウェアの改造がない自動機ルールなど、ロボット競技の裾野を広げるようなルールメイクに感銘を受けて、エントリー締め切り直前に宣言だけしてメンバーを集めました。

実は、この数日前にはオセロAIを観にクマ財団の展示に行っており、「やっぱ芸術物いいな!芸術家目指しても良さそう!」と意気込んでいました。

もしCoRE-1に参加していなかったら「美術館に行こう」みたいなタイトルと共に自由なものづくりをしたいみたいなことを書いていた説があります🎨🙃

一方で、ロボット競技に登場するロボットもものすごい試行錯誤を経て作成されたものであり、他チームが作ったロボットの理解にはものすごい技術的バックグラウンドと自分自身との対話が必要不可欠です。

つまり、ロボコンのロボットは芸術そのものというわけです(?)素晴らしい。🎨🙃

たまたま答えが近くに落ちていたのでしょうか?それともただの勘違い?

少なくともこのようなきっかけになったCoRE運営の方々とクマ財団の展示に行くきっかけを与えたにゃにゃん様には感謝です。

ar-ray.hatenablog.com

元々お金ない学生だったこともあり、価値観がコスパに歪められまくっている悲しい運命ですが、バッテリーがついているならとちょっと奮発しました。

時代はやっぱりコードレスですね。

これをきっかけに品質も重視するようになり、最終的にはiPhone15Proを勢いで購入するまでになります😇

ar-ray.hatenablog.com

この記事を書いている途中、作っておいてほとんど動かしていないことに気づきました😇

急ぎでDynamixelに交換しなければ(コスパisどこ)…

ar-ray.hatenablog.com

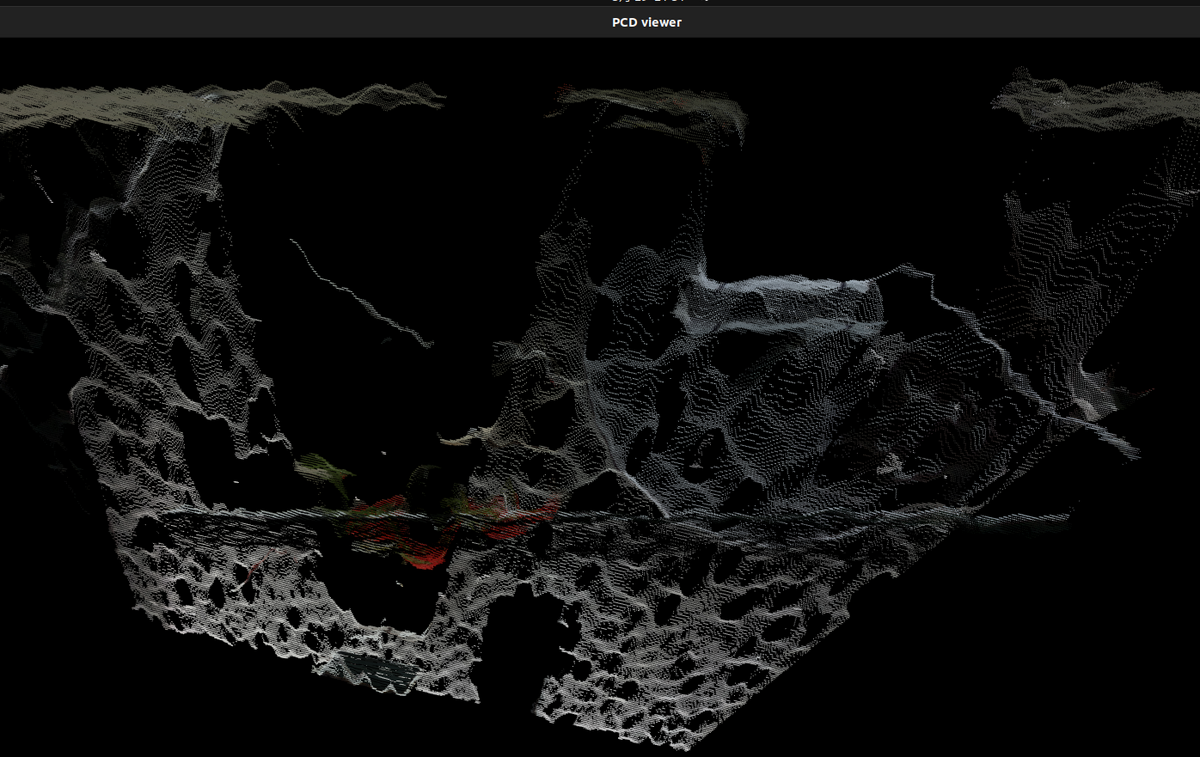

2024年1月はRealSense芸3連発をしていました。

実は最新のカーネルだとRealSense 2台接続しても動くというものです。

RaspberryPi5だともっと快適に動くのかもしれませんね😉

ar-ray.hatenablog.com

2月もRock5しばきしていましたが、ほのぼの回もありました🚎

秋葉には本物の鉄道・バス部品が売っているようなので、ぜひ覗いてみてはいかがでしょうか?

ar-ray.hatenablog.com

実は2023年末にティア某のロボットタクシーのチケットが当たり、乗車体験をしてきました。

人が手を触れない自動運転が日本で見られて満足でした。

さまざまな課題を解決して社会実装される日が来てほしいですね。

ar-ray.hatenablog.com

CoRE-1(自動)に出ます。助けてください!🙏 - えいあーるれいの技術日記 の本番です。

私の力不足もあり、なかなかいいパフォーマンスを発揮できず直前まで調整をしていましたが、久々の限界開発ができて楽しかったです🙃

来年までにソフトウェアやデモ・広報などに力を入れて、注目されるようなチームにしたい!と強く思いました。

今年は集めたパーツでつくチャレ…を考えていましたが、しばらくはCoRE-1の方優先したい!フルコミッターが複数人求められる🙏

部品は全部自分が出せます。

今年度の方針

今年度は昨年からさらに踏み込んでマイコンやLinuxの低レイヤ部分に注力したい!と考えています。

必ず強くなって見せます🙇

さいごに

そもそも私のこれからに興味がある人っているのでしょうか?

いてもいなくても一切理解できない、ひねくれ系よわよわエンジニア🐣ですがこれからもご期待ください。